Xiaomi Robotics-0: Model VLA 4,7 Miliar Parameter untuk Robot Dual-Arm

xiaomi robotics-0 model menggabungkan visi, bahasa, dan kontrol gerak untuk robot; diklaim unggul di benchmark dan uji dunia nyata dual-arm.

Xiaomi memperkenalkan Robotics-0, sebuah model vision-language-action (VLA) dengan sekitar 4,7 miliar parameter yang ditujukan untuk riset robotika. Tujuan utamanya adalah menyatukan kemampuan melihat, memahami instruksi berbahasa manusia, dan mengeksekusi serangkaian gerakan secara mulus pada platform fisik.

Dua komponen inti yang bekerja bersama

Arsitektur Robotics-0 dibangun sebagai Mixture-of-Transformers, yaitu pemisahan tugas agar setiap bagian fokus pada fungsinya. Pendekatan ini membantu menjaga keseimbangan antara pemahaman luas dan kontrol motorik halus.

- Visual Language Model (VLM): berfungsi sebagai 'otak' yang menerjemahkan instruksi manusia dan informasi visual resolusi tinggi menjadi representasi yang bisa dipakai untuk membuat keputusan. VLM menangani deteksi objek, menjawab pertanyaan berbasis gambar, dan penalaran sederhana tentang tata ruang.

- Action Expert (Diffusion Transformer / DiT): bertugas menghasilkan urutan gerakan, bukan hanya satu tindakan tunggal. Model ini membuat apa yang disebut "Action Chunk", rangkaian langkah gerak yang disintesis menggunakan teknik flow-matching agar pergerakan tetap akurat dan halus.

Cara pelatihan dan teknik untuk kestabilan gerak

Pelatihan Robotics-0 dilakukan bertahap untuk menghindari hilangnya kemampuan pemahaman ketika model mulai belajar melakukan aksi fisik. Pertama, ada mekanisme Action Proposal yang memaksa VLM memprediksi distribusi kemungkinan aksi saat menganalisis gambar, sehingga representasi visualnya selaras dengan tindakan yang mungkin diambil.

Setelah tahap tersebut, VLM dibekukan sementara DiT dilatih secara terpisah untuk mengubah noise menjadi urutan aksi yang akurat, memanfaatkan fitur key-value alih-alih token bahasa yang diskrit. Pendekatan co-training ini dimaksudkan agar kemampuan penalaran multimodal tetap terjaga sekaligus memungkinkan pembelajaran kontrol gerak.

- Inferensi asinkron: untuk mengatasi latensi antara prediksi model dan gerakan fisik, sistem memisahkan komputasi model dari operasi robot sehingga pergerakan tetap berkesinambungan meski model membutuhkan waktu berpikir.

- Clean Action Prefix: teknik yang memberi umpan balik berupa aksi sebelumnya ke model agar gerakan berkelanjutan tetap stabil tanpa jitter.

- Λ-shaped attention mask: penyesuaian perhatian yang membuat model lebih menekankan input visual terkini, sehingga robot lebih responsif terhadap perubahan lingkungan yang tiba-tiba.

Hasil benchmark dan uji coba di dunia nyata

Dalam pengujian, Robotics-0 dilaporkan mencapai hasil terdepan pada beberapa benchmark simulasi seperti LIBERO, CALVIN, dan SimplerEnv, mengungguli puluhan model lain dalam tugas yang menguji integrasi penglihatan, bahasa, dan tindakan.

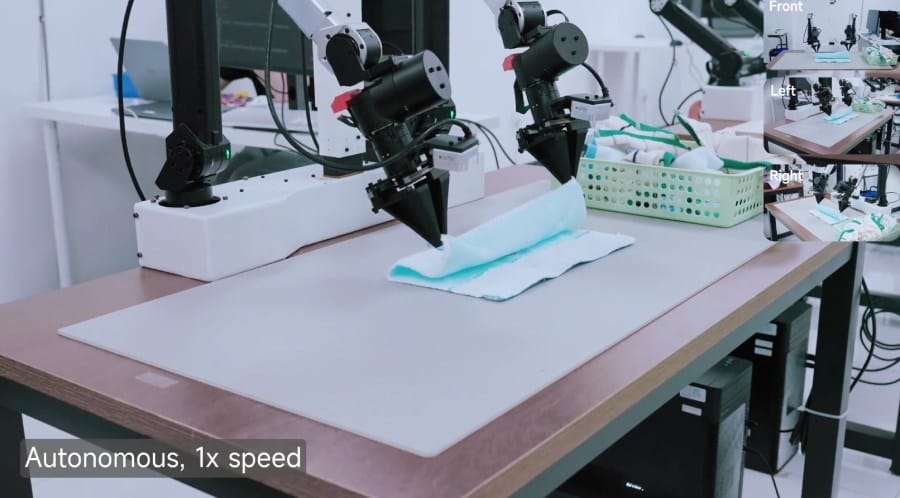

Lebih menarik lagi, model ini juga diterapkan ke platform robot dual-arm untuk uji nyata. Pada tugas jangka panjang seperti melipat handuk dan membongkar susunan balok, robot menunjukkan koordinasi tangan-mata yang stabil serta kemampuan menangani benda kaku dan fleksibel tanpa mengalami kegagalan yang jelas.

Desain yang menjaga kemampuan penalaran visuolinguistik sekaligus memberi perhatian khusus pada kontrol gerak mengurangi trade-off yang sering muncul di model VLA sebelumnya, sehingga Robotics-0 lebih layak dipakai pada eksperimen robotik kompleks yang memerlukan pemahaman dan tindakan sekaligus.

Untuk pengguna yang tertarik dengan perkembangan riset robotika dan aplikasi praktisnya, model seperti Robotics-0 menunjukkan arah di mana kemampuan berbasis visi dan bahasa tidak hanya berlaku untuk antarmuka, tetapi juga mulai mengendalikan tubuh robot secara halus — sebuah langkah yang membaurkan kecerdasan perseptual dengan tindakan fisik dalam konteks penggunaan sehari-hari.